Reporte de la red revela que en seis meses ha eliminado más de tres mil millones de cuentas falsas.

- Comentar

- ico-rs»>Twitter

-

Guardar

Ingrese o regístrese acá

para guardar los artículos en su

zona de usuario y leerlos cuando quieraEste artículo ya fue guardado

Para consultarlo en otro momento, visite su zona de usuario.Artículo guardado

Para consultarlo en otro momento, visite su zona de usuario.El artículo no pudo ser guardado, intente nuevamente

Facebook controla a una red social más de 2.000 millones de usuarios en el mundo. También es dueña de WhatsApp, Messenger e Instagram, cada una de las cuales tiene cerca de 1.000 millones de usuarios.

Aún hay más noticias ¡Sigue bajando!

La red social Facebook publicó un reporte este jueves con impactantes cifras sobre su lucha contra la viralización de la desinformación, el discurso de odio, la apología a la violencia y el acoso contra las poblaciones vulnerables, entre otros.

Con más de tres mil millones de cuentas eliminadas en los últimos seis meses, Facebook presentó un reporte sobre transparencia correspondiente al primer cuatrimestre de 2019 haciendo énfasis en el apabullante volumen de contenido que procesa.

Las cuentas ‘fake’ del último semestre superan la cantidad de personas que usan al gigante de las redes sociales (y sus aplicaciones) todos los meses, incluyendo a la ‘familia’ de Instagram, WhatsApp y Messenger, que son usados por más de 2.700 millones de usuarios en el mundo.

La magnitud de las cuentas eliminadas, solo en los primeros tres meses de 2019, es de 2.19 mil millones.

«Para las cuentas falsas, la cantidad de cuentas por las que tomamos medidas se incrementó debido a los ataques automáticos por parte de actores malos que intentan crear grandes volúmenes de cuentas al mismo tiempo», expresa Facebook.

Esfuerzos de Facebook no son suficientes para Francia pero hay diálogo

Facebook endurece prohibiciones frente al racismo y la xenofobia

Países y empresas se unen en contra del extremismo violento

Contenidos intervenidos

La facultad de Facebook para intervenir en las publicaciones que se dan en su red social ha sido un punto de debate para cientos de reguladores en el mundo. De hecho, las fuertes críticas del excompañero de cuarto de Mark Zuckerberg y cofundador de la red social en sus inicios, hablan en parte de una responsabilidad colosal de Facebook en la protección de la libertad de expresión y la regulación del lenguaje de odio.

Nuestra aplicación no es perfecta y, tan pronto como identificamos un error, trabajamos para solucionarlo

El reporte de la red social da cuenta de cómo actúan sus sistemas de inteligencia artificial especialmente en seis de las áreas de políticas dentro de la red. Según Facebook, su sistema «detecta proactivamente más del 95% del contenido en el que tomamos medidas antes de necesitar que alguien lo informe».

Dicha ‘proactividad’, que se refiere a los casos en los que sin necesidad de que la carga de la denuncia recaiga en los usuarios, ocurre en un 65 del contenido que es eliminado en asuntos como el discurso de odio. La red resalta que ese porcentaje en particular aumentó considerablemente ya que el año pasado, cuando Facebook reveló resultados de sus esfuerzos para cumplir con los compromisos adquiridos con legisladores, el sistema lograba la detección autónoma en un 24 por ciento del contenido borrado.

Durante los primeros tres meses 2019, Facebook eliminó 4 millones de mensajes de odio.

Sin embargo, la intervención en el contenido es más compleja que eliminar publicaciones. En ocasiones, la detección de contenidos que violan las políticas de las redes sociales de propiedad de Facebook requieren revisión humana y pueden tratarse de errores de interpretación.

«Nuestra aplicación no es perfecta y, tan pronto como identificamos un error, trabajamos para solucionarlo», reza el comunicado de la red. Según Facebook, cuando se borra o se limita algún contenido, existe una notificación a los usuarios que publicaron y ofrecen la posibilidad de reportar si creen que hubo un error.

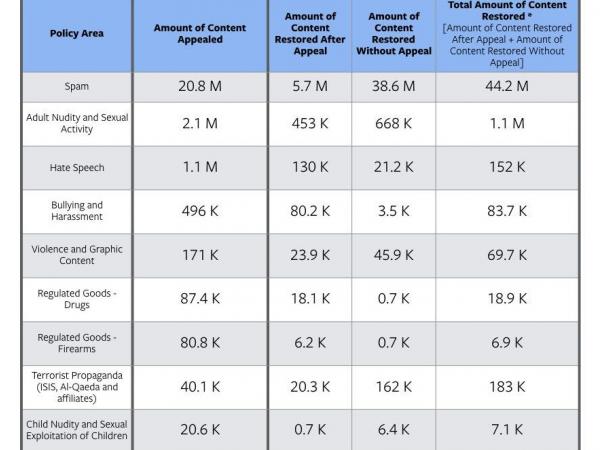

Según el Reporte de Políticas Comunitarias de Facebook para 2019 Q1, las cifras de contenido apelado y restituido varían según el estudio de posibles errores en la intervención

Como lo ilustra la imagen del reporte sobre apelaciones al contenido, en áreas como el acoso y ‘bullying’ o la violencia gráfica las apelaciones son mucho mayores al contenido totalmente restaurado.

En el primero, unas 469.000 publicaciones fueron apeladas por violación de políticas contra el acoso y el ‘bullying’ y solo en 83.400 dichas publicaciones (más publicaciones no apeladas pero detectadas por el sistema con posibles errores) resultaron restauradas. Para el caso de la violencia gráfica, con 171.000 apelaciones, el resultado de restauración total fue por un valor cercano a las 70.000 publicaciones.

Estimamos que el 5% de las cuentas activas mensuales son falsas

¿Qué tan frecuentemente se ven contenidos nocivos?

En uno de los apartados, el reporte habla de la prevalencia, es decir, la frecuencia con la que se vio el contenido que viola las normas de la comunidad de Facebook. La prevalencia habla de cuánto contenido no ha identificado la red social y aún es visible en la red social. Se trata de un muestreo periódico del contenido que se ve en Facebook y de un cálculo sobre el porcentaje que infringe las reglas.

Facebook reveló sus estimaciones en desnudos adultos y actividad sexual, violencia y contenido gráfico y cuentas falsas:

Estiman que por cada 10,000 veces que las personas vieron contenido en Facebook, de 11 a 14 vistas pertenecían a contenido que violaciones a políticas de desnudez y actividad sexual para adultos.

Estimamos por cada 10,000 veces que las personas vieron contenido en Facebook, 25 vistas pertenecían a contenidos calificados como violaciones a políticas de violencia y contenido gráfico.

Por primera vez, el informe incluyó la prevalencia para el terrorismo global y para la explotación sexual y desnudez infantil. En ambas áreas la estimación para el primer trimestre de 2019, fue que por cada 10,000 veces que las personas vieron contenido en Facebook, menos de tres vistas contenían contenido que violaba una de las dos políticas.

Aunque sobre cuentas falsas no hubo números totales, la cifra anunciada establece cuántos perfiles no auténticos sobreviven en la red social sin ser detectados por el sistema.

«Estimamos que el 5% de las cuentas activas mensuales son falsas», reza el informe. En un cálculo estimado de la última cantidad de cuentas activas mensuales reveladas por Facebook en abril de 2018, según cifras de Statista, de 2.342 millones de usuarios, ese 5 por ciento sería equivalente a unas 117 millones de cuentas falsas, que permanecen ocultas y mezcladas entre usuarios reales que al menos abrieron su cuenta de Facebook una vez en el mes.

REDACCIÓN TECNÓSFERA

@TecnosferaET

Descarga la app El Tiempo. Con ella puedes escoger los temas de tu interés y recibir notificaciones de las últimas noticias. Conócela acá

Día clave para esclarecer el futuro de Neymar

Mercado de fichajes El futbolista brasileño se incorpora hoy al PSG y mantendrá una reunió…